INTRODUCCIÓN

La paradoja en cuestión dice lo siguiente:

Dada una bola en el espacio tridimensional, existe una descomposición de la bola en un número finito1 de piezas no solapadas (es decir, subconjuntos disjuntos), que pueden juntarse de nuevo de manera diferente para dar dos copias idénticas de la bola original. Todavía más, el proceso de reensamblaje requiere únicamente remover las piezas y rotarlas, sin cambiar su forma. Sin embargo, las mismas piezas no son "sólidas" en el sentido habitual, sino dispersiones de infinitos puntos.

En resumidas cuentas, dentro de la axiomática ZF de teoría de conjuntos + axioma de elección, es posible hacer pedazos una esfera, y despumes simplemente rotando sus cachos componer dos esferas iguales a la original.

En este texto obtendremos un resultado similar para el caso de un cuadrado. Dividiremos un cuadrado en unas cuantas porciones y cuando las tengamos, con unas rotaciones compondremos dos cuadrados iguales al original.

MULTIPLICANDO LOS CUADRADOS

Primero – clasificar el perímetro

Partiremos de un cuadrado cómo este, cuyo área queremos duplicar.

La primera gran tarea a realizar es la de clasificar todos los puntos que hacen el perímetro del cuadrado en tres conjuntos. La forma de clasificar cada punto del perímetro es el siguiente.

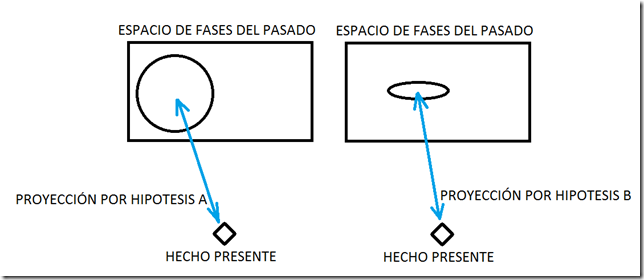

Segundo – mediante proyecciones

Para clasificar se siguen los pasos del siguiente algoritmo, se hace pasar un semirrecta que comenzando en el centro del cuadrado y con dirección norte corte al cuadrado en un punto. El primer punto seria el punto Q tal y cómo se obtiene en la imagen. ¿Hemos rotado el cuadrado cómo ultimo paso para obtenerlo? No, por este motivo lo clasificaremos en el conjunto de los Quietos. Veremos más adelante que clasificaremos los puntos del perímetro en tres conjuntos, quietos [Q], Derechas [D] e Izquierdas [I].

Tercero – se pone en marcha el algoritmo

Iteración n=1

Tenemos cuatro opciones para elegir a continuación;

- Podemos girar el cuadrado a la derecha un numero irracional e+1 (2,718..+1=3,718…) de grados. Recordamos que una vuelta completa tiene 360º. El cuadrado se deja girado, pero no se marca ningún punto de corte con la semirrecta.

- Podemos girar el cuadrado a la derecha un numero irracional e .A continuación marcamos el lugar de corte de la semirrecta con el cuadrado recién girado. El punto marcado pertenecerá al conjunto [D]. Una ver marcado el punto el cuadrado vuelve a la posición original y n=1.

- Podemos girar el cuadrado a la izquierda un numero irracional e+1 (2,718..+1=3,718…) de grados. Recordamos que una vuelta completa tiene 360º. El cuadrado se deja girado, pero no se marca ningún punto de corte con la semirrecta.

- Podemos girar el cuadrado a la izquierda un numero irracional e .A continuación marcamos el lugar de corte de la semirrecta con el cuadrado recién girado. El punto marcado pertenecerá al conjunto [I]. Una ver marcado el cuadrado vuelve a la posición original y n=1.

Vimos que en la primera iteración sumábamos los grados de giro eran e+1 para las opciones 1 y 3. En la siguiente iteración en estas opciones el giro sera de e+0,1. En general para la n-sima iteración el giro para las opciones 1 y 3 será de e+(10/10^n). Este engorro es simplemente para conseguir que la clasificación de cada punto en un conjunto sea unica.

Con esto en mente, la iteración n=2, realizada sobre como ha quedado rotado el cuadrado tras n=1, volverá a plantear las mismas 4 opciones. Con las mismas consecuencias. Vemos que solo sobreviven a la siguiente iteración si elegimos la opción 1 y 3. Las otras conducen a marcar un punto y volver al comienzo.

Quinto – encontrando los puntos perdidos

Después de haber realiza infinitas iteraciones, es hora de ir encontrando los puntos que no han quedado marcados, que son infinitos innumerables. Para ello vamos girando el cuadrado hasta que la semirrecta del norte marque el punto que estaba perdido. Apuntando el punto en el conjunto [Q] de los quietos.

Una vez marcado este punto se vuelve a poner en marcha las iteraciones n=1. Esta posición del cuadrado sera la nueva a la que se volverá después de haber marcado el punto.

Ejecutado el algoritmo otra infinidad de veces, volvemos a girar el cuadrado hasta encontrar un nuevo punto perdido y marcándolo en el conjunto [Q]. Proseguimos de este modo hasta que todos los puntos del cuadrado estén clasificados en [Q], [D] o [I].

¿Cómo es posible ejecutar un algoritmo infinito, que contiene una subrutina que es ademas infinita? No es posible, pero el axioma de elección nos permite adelantar que estos puntos serán marcados sin ejecutar el algorimo, y es lo que nos interesa.

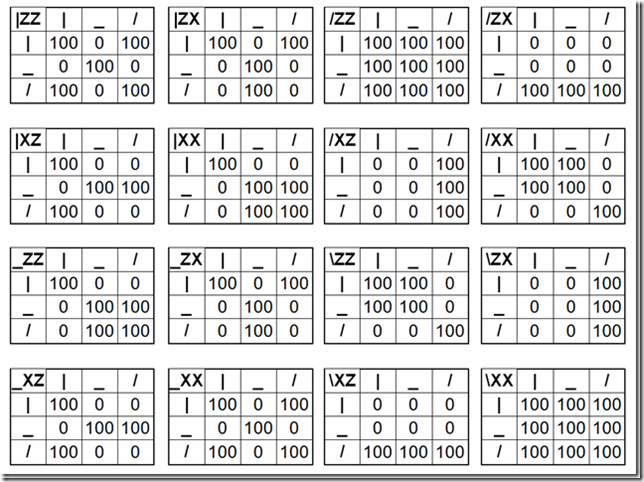

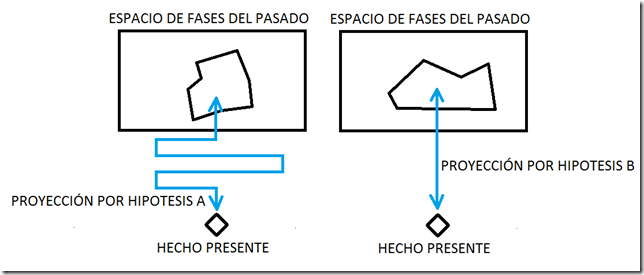

Sexto – una matricula para cada punto

Una forma de identificar cada punto es mediante la secuencia de movimientos izquierda o derecha que se han realizado para alcanzarlo. Por ejemplo el primer punto del ejemplo seria el punto {Q}, si en la siguiente iteración hubiéramos movido el cuadrado a la derecha el punto resultante seria {D,Q}, si en la tercera elegimos mover a la izquierda sería {I,D,Q}. Vemos que los movimientos se escriben de derecha a izquierda. Esto será muy importante más adelante.

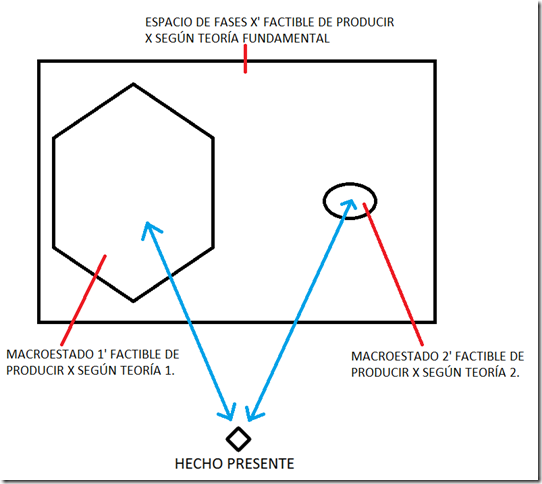

Séptimo – extrayendo los conjuntos

Extraeremos del cuadrado los tres conjuntos de puntos. En principio el perímetro tendría que ser la suma de los tres. De modo que, por ejemplo, el área delimitada por el polígono de infinidad de vértices en el cuadrado [Q] no podrá ser igual al área del cuadrado original.

Octavo – las matriculas de cada conjunto

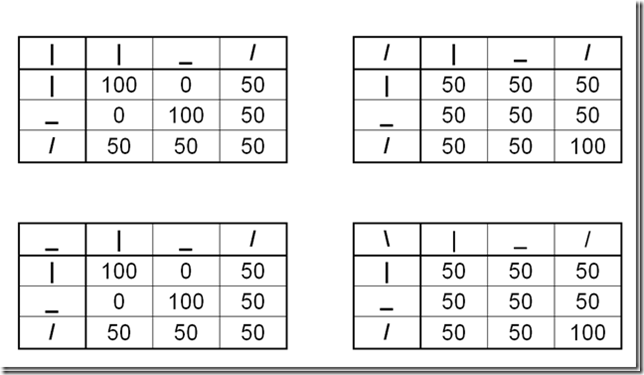

¿Cual es la forma de las matriculas de todos los puntos del cuadrado original? Sabemos que lo constituyen aquellos terminados quietos, a izquierdas y a derechas. Tendran esta forma entonces;

{Q,Q,Q…},{Q,Q,D…},{Q,Q,I…},…….

{D,Q,Q…},{D,Q,D…},{D,Q,I…},…….

{I,Q,Q…},{I,Q,D…},{I,Q,I…},………

¿cual es la matricula de los puntos que pertenecen a I? Sabiendo que terminan en un giro a izquierdas, tienen que tener esta forma;

{I,Q,Q…},{I,Q,D…},{I,Q,I…},………

{I,D,Q…},{I,D,D…},{I,D,I…},………

{I,I,Q…},{I,I,D…},{I,I,I…},………

Noveno – rotando un conjunto se obtiene el total

Ahora vamos a rotar el conjunto [I] hacia la derecha un numero e de grados, esto equivale a añadir una D al final de todas las matriculas. Por tanto el conjunto [I] nos quedaría de la siguiente forma:

{D,I,Q,Q…},{D,I,Q,D…},{D,I,Q,I…},………

{D,I,D,Q…},{D,I,D,D…},{D,I,D,I…},………

{D,I,I,Q…},{D,I,I,D…},{D,I,I,I…},………

Recordamos que tanto la ultima y la penúltima rotaciones en este caso son en ambos casos e y de sentidos contrarios, por tanto se anulan. El conjunto [I] rotado un angulo e nos queda de la siguiente forma:

{

{

{

Esto es tiene la misma forma de todas las matriculas del cuadrado original. Esto es con este giro hemos obtenido un cuadrado original completo. Y tenemos una copia.

Decimo – la segunda copia

Si hacemos lo mismo con el cuadrado [D], pero girándolo a la izquierda e grados, obtenemos nuevamente las matriculas del cuadrado original completo. Y esta es la segunda copia.

¿que pasa con el cuadrado [Q]?, nos sobra.

Consideraciones finales

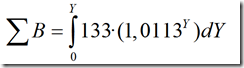

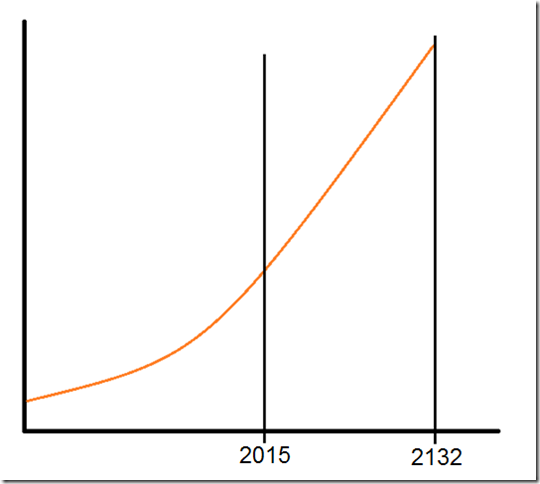

1º A pesar de haber empleado en este texto que el infinito es actual, lo cierto es que entiendo que el infinito ha de tomarse como potencial, y desde este punto de vista no puede construirse ninguna paradoja B-T tal cómo se ha hecho.

2º El presente texto de paradoja B-T en dos dimensiones tiene importantes objeciones.